- Dekking

- Sitemaps

- Verwijderingen

Index rapport Google Search Console

Het index rapport van Google Search Console bestaat uit de volgende onderdelen: Dekking, Sitemaps en Verwijderingen. Het meest gebruikte onderdeel van deze drie, zal het dekkingsrapport zijn. Dit rapport wordt veelal gebruikt om inzicht te krijgen in de indexering, maar ook zeker indexeringsproblemen van een website.Dekking

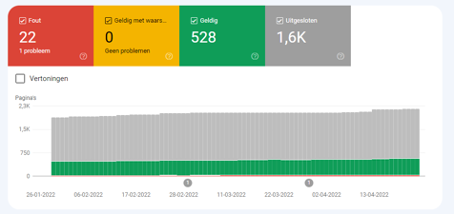

Het indexdekking rapport biedt inzicht in de indexering status van alle URL’s die bij Google bekend zijn van de desbetreffende property. Het rapport is opgedeeld in 4 verschillende statussen, namelijk fout, geldig met waarschuwing, geldig en uitgesloten.

We zoomen als eerste in op de status fout. Hierin vind je vaak de meest kritieke actiepunten die opgelost moeten worden.

Serverfout 5xx

Deze melding geeft aan dat de bot van Google geen toegang kon krijgen tot één of meerdere URL’s van de property. Dit kan meerdere oorzaken hebben. In de meeste gevallen is het een van de volgende problemen:

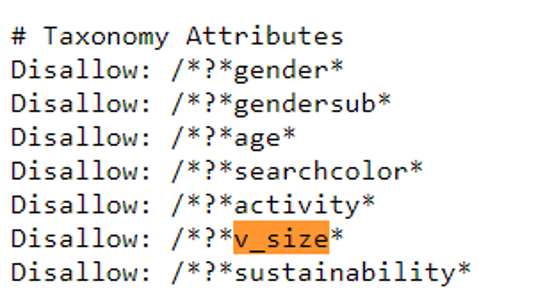

- Het overmatig laden van dynamische pagina’s. Dit kunnen bijvoorbeeld filterpagina’s zijn bij een e-commerce website. Deze pagina’s reageren niet altijd snel genoeg en hierdoor kunnen er serverfouten optreden. Wanneer er niet gewerkt wordt met indexeerbare filters is het daarom goed om de filter parameters uit te sluiten in de robots.txt. Adidas doet dit bijvoorbeeld ook voor de filter opties in de webshop:

https://www.adidas.nl/heren-sneakers?v_size_nl_nl=41

Het rood gemarkeerde gedeelte is als disallow toegevoegd aan de robots.txt van Adidas, hierdoor kan Google deze filter URL niet crawlen:

- De hostingserver kan niet beschikbaar, overbelast of verkeerd geconfigureerd zijn. Neem hierbij contact op met de webhost.

Daarnaast kan het ook zijn dat Google geblokkeerd wordt in bijvoorbeeld de firewall van de website. Neem in dit geval contact op met de hostingprovider of de webbouwer.

Fout met omleiding

Wanneer deze foutmelding wordt gerapporteerd kan dit een van de volgende oorzaken hebben:

- Een te lange omleidingsketen

- Een omleidingslus

- Een omleiding die uiteindelijk de maximale URL-lengte heeft overschreden

- Een onjuiste of lege URL in de omleidingsketen

Het probleem kan gevonden worden door middel van bijvoorbeeld de tool ScreamingFrog. Vaak is de oplossing om een nieuwe redirect in te stellen of een URL te verwijderen.

Ingediende URL geblokkeerd door robots.txt

Hierbij worden pagina’s getoond die wel ingediend zijn voor indexering, maar die niet gecrawld kunnen worden, omdat deze geblokkeerd worden in het robots.txt bestand. Test daarom altijd wanneer er wijzigingen worden doorgevoerd in de robots.txt of dit geen gevolgen heeft voor de indexering van relevante pagina’s. Het robots.txt is zeer gevoelig voor fouten en het uitsluiten van zelfs maar één teken kan ervoor zorgen dat bijvoorbeeld shopping campagnes afgekeurd worden of dat belangrijke pagina’s uitgesloten worden van indexering.

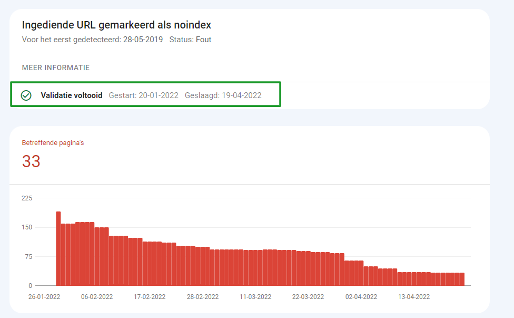

Ingediende URL gemarkeerd als noindex

Hierbij worden de URL’s getoond die een ‘noindex’ metatag bevatten, maar wel ingediend zijn voor indexering. Grote stijgingen bij deze melding hebben vaak grote gevolgen. Bijvoorbeeld wanneer alle product URL’s de metatag ‘noindex’ bevatten, hierdoor kunnen de producten niet worden geïndexeerd door Google. Verwijder dan ook zo snel mogelijk de ‘noindex’ tags van de product URL’s en valideer de oplossing

Hier kan geruime tijd overheen gaan voordat Google alle pagina’s heeft gevalideerd:

Ingediende URL is een soft 404

Soft 404 meldingen zijn pagina’s die wel een succes code hebben (200), maar toch aangeven dat de pagina niet bestaat. Het kunnen bijvoorbeeld ook pagina’s met bijna of geen content zijn, waardoor de pagina niet relevant is voor de gebruiker.

Er zijn in principe 2 manieren om soft 404’s op te lossen.

Optie 1: Wanneer de pagina niet meer relevant en er is ook geen andere pagina met soortgelijke content, om naar te verwijzen, verwijder dan de desbetreffende pagina.

Optie 2: Is er wel soortgelijke relevante content op de website? Redirect (301) dan de soft 404 pagina naar de nieuwe relevante pagina.

Ingediende URL retourneert ongeautoriseerd verzoek (401)

Deze meldingen komen zelden voor. Het geeft dat een pagina wel ingediend is voor indexering, maar dat de Googlebot niet geautoriseerd is. De Googlebot moet geverifieerd worden in de DNS lookup.

Ingediende URL niet gevonden (404)

Dit is een niet-bestaande URL die ingediend is voor indexering. Een 404 melding hoeft niet altijd verholpen te worden. Als het bijvoorbeeld een bewust verwijderde pagina is, die ook niet geredirect kan worden naar een gerelateerde pagina, is een 404 code de juiste oplossing. Wanneer er wel een andere pagina is die gerelateerd is aan de 404 pagina, is het goed om een redirect toe te voegen naar deze andere pagina. Hierdoor wordt de gebruiker en Google doorverwezen naar een andere relevante en gerelateerde pagina.

Ingediende URL heeft 403 geretourneerd

De server geeft Google geen toegang tot de pagina. Vaak zit de fout in .htaccess bestand of dat de onjuiste rechten worden gegeven. Schakel in ieder geval de webbouwer in bij deze foutmelding.

Ingediende URL geblokkeerd vanwege ander 4xx-probleem

Deze foutcode geeft aan dat er een probleem is die niet onder de bovenstaande foutcodes valt. Gebruik in dit geval bijvoorbeeld een tool als ScreamingFrog of de URL-inspectie tool binnen Google Search Console om het probleem te achterhalen:

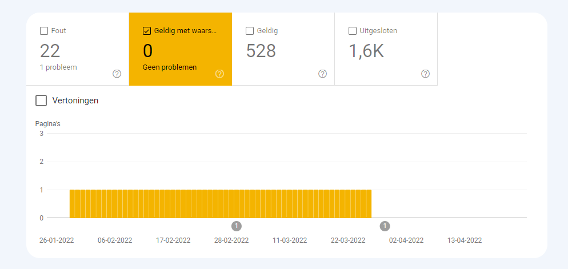

Geldig met waarschuwing

Hierbij geeft Google Search Console inzicht in pagina’s die wel geïndexeerd zijn, maar waarbij zich fouten voordoen.

Geldig

In dit rapport wordt iedere URL getoond die een geldige statuscode (200) bevat en geïndexeerd is door Google.

Ingediend en geïndexeerd

De URL is ingediend voor indexering en deze is ook geïndexeerd door Google.

Geïndexeerd, niet ingediend in sitemap

De URL is geïndexeerd door Google, maar staat niet in de sitemap. Wij adviseren om de belangrijkste URL’s zoals product-, categorie- en blogpagina’s altijd toe te voegen aan de sitemap.

Uitgesloten

In dit rapport worden pagina’s getoond die niet geïndexeerd zijn en deze zijn in het uitgesloten rapport geplaatst, omdat Google inschat dat het geen fout is dat deze pagina’s niet geïndexeerd worden.

Uitgesloten door de tag ‘noindex’

Dit zijn pagina’s waarbij er een metatag ‘noindex’ is aangetroffen, zodat Google deze pagina’s niet indexeert. Zitten hier pagina’s tussen die wel geïndexeerd moeten worden? Dan is het noodzakelijk dat de noindex tag verwijderd wordt op deze pagina’s.

Geblokkeerd door tool voor paginaverwijdering

Dit zijn pagina’s die door middel van de Verwijderings tool binnen Google Search Console geblokkeerd worden. Hierbij kunnen er URL’s tijdelijk geblokkeerd worden voor Google:

Geblokkeerd door robots.txt

Het robots.txt bestand blokkeert dat de pagina’s gecrawld worden door de Googlebot. Staan hier pagina’s in die wel gecrawld en geïndexeerd dienen te worden, dan moet het robots.txt bestand worden aangepast.

Let op: Een pagina kan altijd nog geïndexeerd worden door Google, ondanks dat deze geblokkeerd wordt in de robots.txt. Mag een bepaalde pagina echt niet geïndexeerd worden door Google, voeg dan een ‘noindex’ metatag toe op de pagina.

Geblokkeerd wegens ongeautoriseerd verzoek (401)

De pagina is geblokkeerd voor de Googlebot door een verzoek tot autorisatie. Vaak is dit aan te passen in de DNS lookup.

Gecrawld – momenteel niet geïndexeerd

Dit zijn pagina’s die wel door Google zijn gecrawld, maar niet opgenomen zijn in de index van Google. Simpel gezegd: Google beoordeelde de pagina als niet relevant genoeg om de pagina op te nemen in de index van de zoekresultaten. Er zijn diverse acties die toegepast kunnen worden om de indexeringskans te verhogen:

- Meer interne links toevoegen die verwijzen naar de niet geïndexeerde pagina.

- Content uitbreiden op de desbetreffende pagina, zodat Google beter kan beoordelen voor welke zoekwoorden de pagina relevant is.

- Backlink profiel opbouwen voor de niet geïndexeerde pagina.

Gevonden – momenteel niet geïndexeerd

Dit houdt in dat de pagina wel is gevonden door Google, maar dat de Googlebot deze niet heeft gecrawld. Vaak is de oorzaak hiervan dat de site overbelast was, waardoor de Googlebot is gestopt met crawlen.

Alternatieve pagina met correcte canonieke tag

Hier wordt er een overzicht getoond van pagina duplicaten die door middel van een canonical tag verwijzen naar de originele pagina. Google heeft deze pagina’s dus niet geïndexeerd, omdat deze met een canonical verwijzen naar een andere pagina.

Dubbele pagina zonder door de gebruiker geselecteerde canonieke versie

Dit is een overzicht van dubbele pagina’s waarbij er niet is aangegeven welke pagina het origineel is. Voeg bij deze pagina’s canonical tags toe naar de juiste pagina’s.

Niet gevonden (404)

Google vindt deze pagina’s nog steeds zonder een verzoek of sitemap. Het zijn pagina’s die voorheen wellicht nog bestonden en nu zijn verwijderd. Het is geen probleem, zolang deze pagina’s bewust zijn verwijderd. Wanneer de pagina verplaats moet worden, dan is het wel noodzakelijk om een redirect (301) door te voeren.

Pagina met omleiding

Dit zijn pagina’s die Google is tegengekomen op de website en dat deze URL’s geredirect worden. Dit zorgt over het algemeen niet voor problemen. Tenzij er in de footer of in het hoofdmenu er een link geredirect wordt. Hierdoor wordt Google constant geredirect, omdat het hoofdmenu en de footer op elke pagina terugkomt. In dit geval is het wel belangrijk om de link aan te passen naar de nieuwe URL.

Soft 404

Soft 404’s zijn meldingen die ontstaan doordat de pagina een reactie retourneert die Google beschouwd als een soft 404. Hierbij wordt er vaak op de pagina aangegeven dat de pagina niet gevonden is, maar er geen 404 code op staat. De soft 404’s zijn op twee manieren op te lossen:

- Een 404 statuscode toevoegen op de pagina’s.

- De pagina’s redirecten wanneer er een andere relevante pagina is voor de gebruiker.

Dubbele pagina, ingediende URL niet geselecteerd als canoniek

Google heeft hierbij een pagina gevonden die een duplicaat is van een andere pagina. Er is echter geen canonical tag gevonden op de duplicate pagina, waardoor Google zelf de canonieke URL kiest en indexeert. Het is goed om alsnog een canonical tag toe te voegen op de duplicate pagina.

Geblokkeerd vanwege verboden toegang (403)

De Googlebot heeft bij deze pagina’s geen toegang, waardoor deze pagina’s ook niet gecrawld en geïndexeerd kunnen worden.

Geblokkeerd vanwege ander 4xx-problemen

Er zijn 4xx fouten aangetroffen die niet vallen onder een van de bovenstaande meldingen. Hierbij is het wederom goed om ScreamingFrog of de URL-inspectie tool in Google Search Console te gebruiken om het probleem te achterhalen.

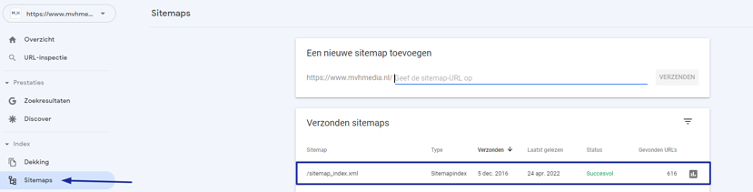

Sitemaps

De sitemap is een soort ‘plattegrond’ van een website. Hierin staan alle URL’s in die geïndexeerd dienen te worden, denk hierbij aan:

- Product URL’s

- Categorie URL’s

- Blogpagina’s

- Overige pagina’s

- Afbeeldingen (optioneel)

Deze sitemaps dienen ingediend te worden bij Google Search Console:

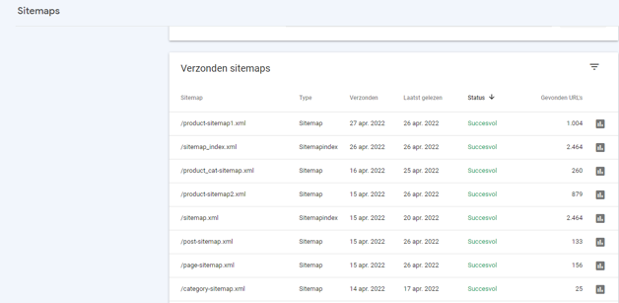

Tip: Dien de verschillende sitemaps ook apart in bij Google Search Console:

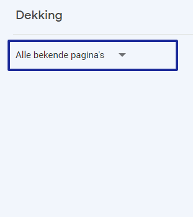

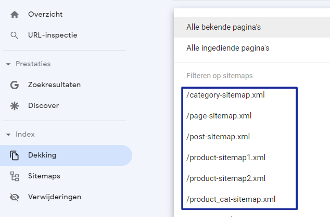

Hierdoor is het mogelijk om bij het dekkingsrapport ook te filteren op een bepaalde sitemap, waardoor issues per sitemap achterhaalt kunnen worden:

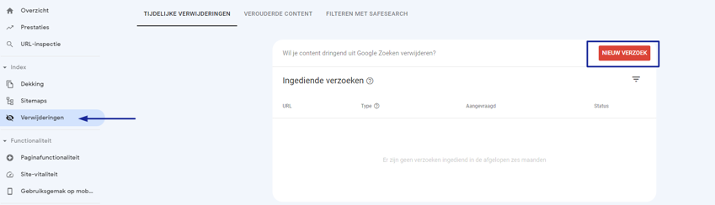

Verwijderingen

De verwijderingstool zal minder vaak gebruikt worden over het algemeen. Deze wordt over het algemeen alleen gebruikt bij een van de volgende situaties:- Als een URL snel uit de Google zoekresultaten moeten worden gehaald en het geen optie is om te wachten totdat Google weer de URL crawlt.

- Er is gevoelige content op de pagina geüpdatet en Google moet de wijzigingen in de zoekresultaten weergeven.

Conclusie

Het indexdekkingsrapport van Google Search Console biedt dus veel technische inzichten over de indexeerbaarheid van de desbetreffende property. Een veelgebruikt rapport door SEO’ers, online marketeers en webbeheerders. Over het algemeen geldt: Wanneer er plotseling een grote stijging of daling is in de grafieken van dit rapport, betekent dit dat er iets mis is en dat er acties ondernomen moeten worden. Hieronder de belangrijkste punten op een rij:

Kijk regelmatig in het dekkingsrapport om indexeringsproblemen te detecteren en hierop actie te kunnen ondernemen.

- Dien altijd de sitemap in bij Google Search Console.

- Dien ook de specifieke sitemaps in bij Google Search Console, zodat eventuele issues met een specifieke sitemap snel in het dekkingsrapport te achterhalen zijn.

Heb je nog vragen aan de hand van dit artikel of wellicht hele andere vragen wat betreft de gehele SEO-strategie? Ons team van SEO-specialisten beantwoorden graag al je vragen. Neem gerust een vrijblijvend contact op.